Il y a quelques jours le prix 2011 du « Meilleur jeune économiste français » a été décerné à Xavier Gabaix, qui travaille et enseigne à l’Université de New-York. En collaboration avec des physiciens, il s’est notamment penché sur la question des fluctuations des marchés financiers, et a proposé un modèle pour tenter d’expliquer l’universalité de ces fluctuations.

Il y a quelques jours le prix 2011 du « Meilleur jeune économiste français » a été décerné à Xavier Gabaix, qui travaille et enseigne à l’Université de New-York. En collaboration avec des physiciens, il s’est notamment penché sur la question des fluctuations des marchés financiers, et a proposé un modèle pour tenter d’expliquer l’universalité de ces fluctuations.

Les fluctuations du CAC40

On le sait bien, les marchés financiers fluctuent, et ce de manière apparemment imprévisible. Mais en analysant un historique de ces fluctuations, on peut observer des choses intéressantes, notamment mesurer la probabilité d’apparition des évènements extrêmes que sont les fortes hausses ou fortes baisses.

On le sait bien, les marchés financiers fluctuent, et ce de manière apparemment imprévisible. Mais en analysant un historique de ces fluctuations, on peut observer des choses intéressantes, notamment mesurer la probabilité d’apparition des évènements extrêmes que sont les fortes hausses ou fortes baisses.

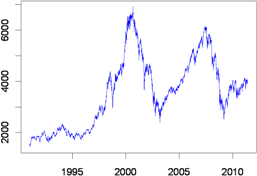

Prenons notre bon vieux CAC40, et regardons son historique depuis une vingtaine d’années (ci-contre). On va s’intéresser à ses fluctuations d’un jour sur l’autre, exprimées en pourcentage. Vous savez ce chiffre que nous annonce le présentateur à la fin du journal télé « La bourse de Paris a clôturé en baisse de 2.12% ».

Faisons un peu de statistiques sur ces chiffres. Avec 20 ans d’historique et environ 250 jours d’ouverture par an, je dispose d’une liste de 5162 fluctuations de ce genre. Pour se faire une idée de la probabilité des différentes fluctuations, on peut en tracer l’histogramme (voir ci-contre).

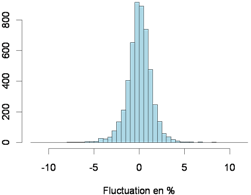

Faisons un peu de statistiques sur ces chiffres. Avec 20 ans d’historique et environ 250 jours d’ouverture par an, je dispose d’une liste de 5162 fluctuations de ce genre. Pour se faire une idée de la probabilité des différentes fluctuations, on peut en tracer l’histogramme (voir ci-contre).

On y voit que la très grande majorité du temps, la fluctuation est comprise entre -2% et 2%. Au global, cet histogramme semble avoir une bonne tête de « courbe en cloche », cette courbe qui représente la distribution gaussienne. Et pourtant quand on y regarde de près, cette allure de courbe en cloche est trompeuse, car les fluctuations du CAC40 ne sont pas du tout gaussiennes !

C’est particulièrement apparent quand on regarde les fluctuations extrêmes, ces jours où la bourse monte de plus de 3% ou baisse de plus de 3%. En effet la gaussienne est une distribution qui prédit très peu d’évènements extrêmes, et vous allez voir que notre CAC40 en comporte plein !

Le CAC40 a une queue épaisse

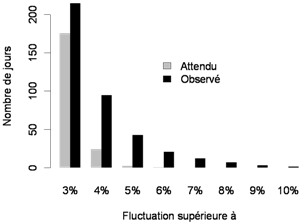

Pour mettre en lumière ces fluctuations extrêmes, on peut dénombrer dans notre historique de 20 ans le nombre de fois où la fluctuation a dépassé un certain seuil, et comparer à ce qu’on aurait attendu si les fluctuations étaient gaussiennes.

Pour mettre en lumière ces fluctuations extrêmes, on peut dénombrer dans notre historique de 20 ans le nombre de fois où la fluctuation a dépassé un certain seuil, et comparer à ce qu’on aurait attendu si les fluctuations étaient gaussiennes.

Le résultat est présenté ci-contre : on y lit par exemple que sur ces 20 ans d’historique, le CAC40 a dépassé 43 fois le seuil de fluctuation de 5%. Il y a donc eu 43 jours sur 5162 où le présentateur a annoncé une hausse de plus 5% ou une baisse de plus de 5%.

Si les fluctuations étaient gaussiennes, un tel seuil n’aurait dû être franchit qu’environ 2 fois en 20 ans ! Et les chiffres sont encore plus impressionnants à des seuils plus élevés, puisque si les fluctuations étaient gaussiennes, on n’aurait pour ainsi dire jamais vu de fluctuations supérieures à 6 ou 7%. Or il s’en produit en moyenne une par an !

Le CAC40 ne fluctue pas comme une gaussienne, car il contient beaucoup d’évènement extrêmes (en positif comme en négatif). La distribution de ses fluctuations appartient au régime des distributions dites « à queue épaisse » (fat tail en anglais). La queue de la distribution n’est pas négligeable, et des évènements extrêmes n’y sont pas improbables.

L’universalité des fluctuations

En utilisant des bases de données de transactions boursières, il est possible d’analyser et de comparer les fluctuations extrêmes de nombreux actifs financiers : des indices (comme le CAC40), des actions, des taux de change, des prix de matières premières, etc. Et le résultat est sidérant : les fluctuations sont toutes à queue épaisses, et surtout toutes ces queues épaisses sont identiques !

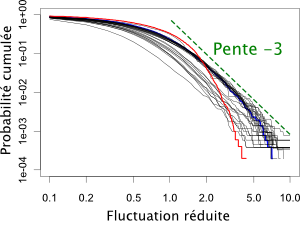

Voyons comment l’on quantifie cela. Ce qui nous intéresse, ce sont les cas de fluctuations importantes, et notamment la probabilité qu’une de ces fluctuations importantes survienne. Pour cela on définit P(x), la probabilité que la fluctuation (en valeur absolue) dépasse x. Dans mon exemple du CAC40, dans 43 cas (sur 5162) la fluctuation a dépassé 5%. Donc P(>5%) = 43/5162=0.0083.

Pour caractériser la queue épaisse, on regarde comment se comporte P(x) quand x augmente. Le résultat est incroyable : quel que soit le pays, le marché ou l’actif financier que l’on regarde, cette probabilité décroit avec la même loi, qui est une loi dite « de puissance » caractérisée par un exposant -3. En langage des maths ça donne :

\(P(x) \sim x^{-3}\)

A ce stade de l’analyse, il s’agit d’une relation totalement empirique, et rien n’explique pourquoi il en est ainsi. Pourquoi un coefficient -3 plutôt que -2.4 ou -8.43 ? Et surtout pourquoi ce comportement est-il universel, indépendant de l’actif financier que l’on regarde.

Comme parfois je ne crois que ce que je vois, j’ai voulu vérifier cette relation en utilisant l’excellent logiciel de statistique R. Le résultat se trouve ci-contre (et pour les bourrins le code est là) J’ai utilisé les données de tout un tas d’actions côtées sur différents marchés (Paris, Wall-Street, Francfort…), pour chacune d’elle j’ai calculé la probabilité empirique P(x), et j’ai tracé cette probabilité en échelle log-log.

Comme parfois je ne crois que ce que je vois, j’ai voulu vérifier cette relation en utilisant l’excellent logiciel de statistique R. Le résultat se trouve ci-contre (et pour les bourrins le code est là) J’ai utilisé les données de tout un tas d’actions côtées sur différents marchés (Paris, Wall-Street, Francfort…), pour chacune d’elle j’ai calculé la probabilité empirique P(x), et j’ai tracé cette probabilité en échelle log-log.

On y observe que toutes les courbes ont effectivement une pente de -3 pour les fluctuations suffisamment grandes ! (à partir de 2 fois la déviation standard) La courbe en bleu est le CAC40 et la courbe en rouge indique la courbe qu’on aurait si les fluctuations étaient gaussiennes. On voit nettement la différence, et le fait que les fluctuations extrêmes sont bien plus fréquentes que si la distribution était gaussienne.

Encore plus universel que ce qu’on croyait !

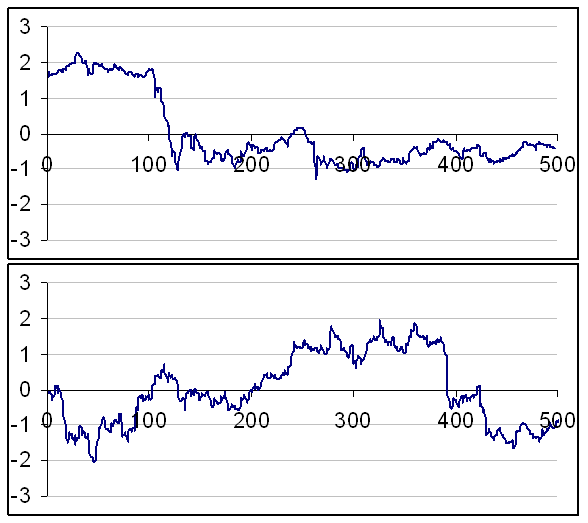

Regardez les deux courbes ci-dessous, elles fluctuent toutes les deux. Mais voyez-vous une différence dans la manière dont elles fluctuent ?

A priori pas de grosse différence qualitative ou quantitative. Et pourtant ces deux courbes ont des origines radicalement différentes. La première représente les fluctuations du cours de l’action Coca-Cola, enregistré toutes les minutes pendant 2 jours (entre le 17/06/2003 à 11h28 et le 18/06/2003 à 13h27). La seconde représente aussi les fluctuations du cours de l’action Coca-Cola, mais enregistrée tous les jours pendant 2 ans (entre le 01/01/2003 et le 31/12/2004).

Les fluctuations du cours sont fractales : elles se ressemblent à l’échelle d’une minute pendant un jour et à l’échelle d’une journée pendant un an ! C’est d’ailleurs Benoît Mandelbrot qui a le premier observé un phénomène de ce type en analysant les cours du coton.

Et là devinez quoi ? Les fluctuations à l’échelle d’une minute obéissent elles aussi à la loi universelle de décroissance en puissance -3 ! [1] Quelle que soit l’échelle d’analyse et l’actif financier considéré, cette loi semble valable, et cela a été vérifié pour des échelles de 1 minute à 1 mois !

A la recherche d’une explication

Une telle constatation empirique mérite bien qu’on en cherche une explication théorique ! C’est ce qu’ont essayé de faire Xavier Gabaix et ses collègues physiciens. En 2003, ils ont publié dans Nature [2] un modèle à même d’expliquer l’universalité de la loi de fluctuation en puissance -3.

Ce modèle repose sur des hypothèses plutôt simples. Il part du principe que les variations des cours surviennent principalement sous l’impulsion des gros investisseurs (des fonds d’investissement), et que 1) ces gros investisseurs sont tous aussi efficaces les uns que les autres, 2) ils se comportent de manière « optimale » et 3) leur taille est distribuée selon une certaine loi (vérifiée empiriquement).

Ce modèle repose sur des hypothèses plutôt simples. Il part du principe que les variations des cours surviennent principalement sous l’impulsion des gros investisseurs (des fonds d’investissement), et que 1) ces gros investisseurs sont tous aussi efficaces les uns que les autres, 2) ils se comportent de manière « optimale » et 3) leur taille est distribuée selon une certaine loi (vérifiée empiriquement).

Le comportement optimal des gros investisseurs est traduit dans le modèle par le fait que quand ils souhaitent acheter (ou céder) des actifs, ils proposent un prix qui est un compromis optimal entre ce qu’ils pensent être le prix juste, et leur volonté de réaliser la transaction assez rapidement (le dilemme classique du vendeur immobilier).

Des hypothèses de ce modèle découle la loi de fluctuations en puissance -3 ! Un peu d’économie théorique dans Nature, ça n’arrive pas si souvent, et c’est rafraîchissant !

[1] P. Gopikrishnan et al., Scaling of the distribution of fluctuations of financial market indices, Physical Review E 60 (1999) p5305 – cond-mat/9905305

[2] X. Gabaix et al., A theory of power-law distributions in financial market fluctuations, Nature 423 (2003) p267

12 Comments

Très intéressant, merci de parler de ce sujet qui a permis a tant de mathématiciens d’avoir de prix Nobel (en effet, ils raflent tous le prix Nobel d’économie 😉 )

Fascinant cette explication. Mais je n’ai pas compris pourquoi on tombe toujours sur un facteur 3?

Bon il faut se plonger un peu dans le papier (qui est là) mais rien d’insurmontable.

On procède en deux temps :

– on s’intéresse d’abord aux volumes échangés, c’est à dire la probabilité des évènements extrêmes où on dépasse un certain volume P(V>x). En partant du principe que les fonds de pensions sont distribués selon une loi « de Zipf » (en 1/S où S est la taille du fond), et que les fonds ont tous une efficacité égale, il calcule la distribution des fréquences et des volumes échangés, et montre que la fonction de répartition a un exposant 1.5.

– puis dans un second temps on montre que les loi de probabilité en volume et en fluctuation sont reliés par un facteur 2, et ce à cause de l’optimalité des investisseurs qui choisissent toujours le bon prix pour à la fois faire une bonne opération et assez rapidement.

Dans le papier c’est présenté dans l’ordre inverse, il montre d’abord la relation volume/retours, puis démontre le facteur 1.5 sur les volumes.

Pour comprendre le regard des physiciens sur la bourse, je conseille vivement le bouquin de Jean-Philippe Bouchaud et al « Theory of Financial Risk and Derivate Pricing ». Benoît Mandelbrot a aussi écrit des livres « broad audience » expliquant l’ecart à la normalité des fluctuations de la bourse.

Excellent article. Petite question subsidiaire…

Si la distribution des variations du CAC sur une échelle de temps T était parfaitement gaussienne (ou autre mais symétrique et centrée sur zéro), cela imposerait-il au CAC d’osciller autour d’une valeur constante sur échelle de temps 365xT ? Par exemple l’enchainement de 4 jours : +2% +1% -2% -1% ne fait pas zéro (ça fait -0,5%)… donc on peut imaginer des scénarios ou sur l’échelle de temps T pour lesquels la distrib des variations est centrée sur zéro mais sur une echelle plus longue pas du tout. Par exemple l’action apple a fait +200% depuis 2009… Pour faire une distrib symétrique sur les 2 prochaines année, ça va faire mal…

Oui en fait la moyenne est très très légérement positive (+0.03% par jour en moyenne sur les 20 dernières années), et ça suffit à engendrer un CAC qui globalement double ou triple en 20 ans.

« +0.03% par jour en moyenne sur les 20 dernières années » Dans l’hypothèse d’une évolution fractale il faut s’attendre à du -0,03% par jour à partir de… bientôt ?

ha… on peut donc mettre le comportement de groupes humains en équation… c’est une hypothèse qui me parait bien forte !

je rajouterais que ce n’est pas parce qu’un modèle décrit une certaine forme de la réalité à peu près correctement qu’il n’en est pas moins à mettre à la benne…

Oui, d’ailleurs ta remarque est valide pour n’importe quel modèle dans n’importe quelle discipline de n’importe quelle science. Les phénomènes peuvent se mettre en équation, avec des limites, et les modèles décrivent certains aspects de la réalité, jusqu’à ce qu’on les détrône. Rien de choquant à cela, juste la marche normale de la science…

Pingback: Propagation d’épidémies et graphes aléatoires | Science étonnante

Pingback: Un singe ferait-il mieux que votre conseiller financier ? | Science étonnante