La nouvelle a fait grand bruit parmi les chercheurs : d’après un statisticien américain, il se pourrait que presque 25% des résultats publiés dans littérature scientifique soient tout simplement faux.

La nouvelle a fait grand bruit parmi les chercheurs : d’après un statisticien américain, il se pourrait que presque 25% des résultats publiés dans littérature scientifique soient tout simplement faux.

Voilà qui ne va pas aider la science, déjà pas mal discréditée aux yeux d’une partie de nos concitoyens. Mais qu’est-ce que cette nouvelle veut dire ?

Pour le comprendre, il faut se pencher sur la méthode scientifique que les chercheurs utilisent pour valider leurs résultats, celle qui leur permet de décider si oui ou non ils ont vraiment trouvé quelque chose.

Une petite expérience entre amis

Vous êtes avec un groupe d’amis en train de papoter, quand soudain l’un d’eux lance « En fait, contrairement à ce qu’on dit toujours, les femmes sont en moyenne plus grandes que les hommes dans la population ». Quoi ? Ah bon ? « Oui, je peux le prouver ! » répond-il.

Votre ami mesure alors les uns après les autres les membres du groupe, et voici les résultats :

Conclusion : eh bien en moyenne les femmes sont légèrement plus grandes que les hommes ! Alors, qu’en dites-vous ?

Évidemment, ça ne va pas ! Sur le groupe, c’est vrai que les femmes sont plus grandes, mais c’est vraiment pas de bol. Si on avait pris un autre groupe ou un groupe plus important, on aurait certainement pas eu ce résultat.

Si nous sommes arrivés à cette conclusion (les femmes sont plus grandes), ça n’est pas parce que le phénomène est vrai, mais simplement à cause du hasard. Nous avons obtenu ce qu’on appelle un faux positif.

Dans beaucoup de domaines de la science se pose la même question : comment être sûr que ce que l’on a découvert est bien réel, et pas simplement un faux positif dû au hasard ?

Un exemple plus scientifique

Un exemple plus scientifique

Imaginons que vous vouliez prouver l’influence d’un gène donné sur le fait de développer de l’hypertension. Il vous faut pour cela un groupe de personnes possédant ce gène, ainsi qu’un groupe qui ne le possède pas.

Imaginons que nous ayons réuni 20 personnes dans chaque groupe. On mesure la tension artérielle de tout ce petit monde, on calcule la moyenne et l’écart-type dans chacun des deux groupes.

Voici les résultats obtenus :

D’après ces mesures, les gens qui possèdent le gène ont en moyenne une tension plus élevée, mais d’un autre côté les écarts-types ne sont pas négligeables. Alors a-t-on le droit de clamer une découverte scientifique et de la publier ? Ou bien y-a-t-il un risque que cela soit un faux-positif obtenu par hasard ?

Intuitivement, on sent bien que le risque de faux positif dépend :

- de la taille de l’écart observé : plus l’écart entre les moyennes des deux groupes est grand, plus le risque est faible;

- de la valeur des écarts-types : plus ils sont petits, plus le risque est faible;

- du nombre de personnes testées : plus il y en a, plus le risque est faible.

Pour quantifier précisément le risque de faux-positif, les scientifiques utilisent une valeur statistique appelée « le petit p ».

La dictature du « petit p »

Le « petit p » sert à traduire le risque de faux positif, c’est-à-dire la probabilité d’observer un effet dans les données juste par chance, même si l’effet n’existe pas en réalité. Cette probabilité peut s’estimer à partir des données expérimentales que l’on a recueillies, et elle dépend de la taille de l’effet observé, des écarts-types et du nombre de cas mesuré.

Plus le « petit p » est faible, plus les scientifiques sont contents car cela indique que ce qu’ils voient dans leur expérience a de bonne chances d’être réel, et pas simplement dû au hasard. Dans les deux exemples que j’ai donné, le petit p aurait été de 0,85 pour les mesures de taille (énorme risque de faux positif), et plutôt autour de 0,01 pour l’exemple sur le gène de l’hypertension.

Conventionnellement, les scientifiques considèrent qu’un résultat est recevable si le petit p est inférieur à 0,05, c’est-à-dire si les résultats que vous obtenez ont moins de 5% de risque d’être dus au hasard. Un résultat avec p < 0,05 est dit « statistiquement significatif », et c’est le sésame pour pouvoir le publier. Clairement la conclusion tirée sur la mesure des tailles (les femmes sont plus grandes) n’est pas statistiquement significative, alors que la conclusion sur le gène favorisant l’hypertension est assez robuste et pourrait être publiée.

Vous pouvez prendre n’importe quel article biomédical, de sciences sociales ou de neurosciences : il y a de fortes chances pour qu’il mentionne les « petits p » des expériences comme étant inférieurs à 0,05, pour prouver que c’est du solide.

Ce qu’il y a d’étonnant, c’est que bien qu’il s’agisse d’une convention, ce seuil de 0,05 règne en maître absolu sur le destin des chercheurs, et ce de manière totalement binaire : vous pouvez voir des scientifiques passer du rire aux larmes suivant que le « petit p » de leur résultat sera 0,053 ou 0,048. Avec p=0,048, à eux la publication, la gloire et les paillettes; avec 0,053, ils peuvent jeter leur travail à la poubelle. Ce seuil artificiel et binaire peut paraître ridicule, mais c’est souvent comme ça que ça se passe.

Au passage notez que la plupart des affirmations de comptoir du genre « Ma soeur a eu la grippe; tandis que sa voisine qui prend de l’homéopathie ne l’a pas eu » auraient un « petit p » bien ridicule ! Malheureusement c’est vrai aussi de beaucoup d’affirmations en provenance d’hommes politiques ou de journalistes prétendument économiques, du genre : « Il faut taxer les fours micro-ondes. Regardez, le Kyrgyzstan a voté une loi sur la taxation des fours micro-ondes, et depuis l’inflation a diminué« .

Mais revenons à la science et à l’article qui fait débat.

La critique de Valen Johnson, et autres travers du petit p

Ce couperet du « p<0,05 » existe depuis des dizaines d’années, et comme je l’ai dit, il fait la pluie et le beau temps pour beaucoup de chercheurs en biologie, médecine ou sciences sociales. Mais voici que Valen Johnson, chercheur en statistiques à l’Université du Texas, vient de jeter un pavé dans la mare en argumentant que cette valeur seuil conventionnelle de 0,05 serait bien trop laxiste, et laisserait passer beaucoup trop de faux positifs (jusqu’à un 25% d’après ses calculs). Pour éviter cela, Johnson recommande plutôt de prendre un seuil beaucoup plus strict de 0.005 voire 0.001 ! Bien entendu, cela signifierait que beaucoup d’études aujourd’hui publiées ne passeraient pas le seuil fatidique et ne seraient donc pas recevables !

Sans aller jusqu’aux calculs savants de Johnson, il existe une critique classique que l’on fait à ce seuil de 0,05. Imaginons que vous fassiez une expérience concernant un effet qui dans la réalité n’existe pas (mais vous ne le savez pas). Vous allez très certainement trouver un p supérieur à 0,05. Mais si vous faites l’expérience suffisamment de fois (20 fois en moyenne), vous allez bien finir par avoir de la chance et trouver un « petit p » inférieur au seuil de 0,05.

Maintenant supposons que vous ne fassiez l’expérience qu’une seule fois, mais que 20 autres équipes de recherche dans le monde fassent la même : il y en a bien une sur les 20 qui va avoir de la chance et obtenir p<0,05. Cette dernière pourra publier ses résultats, et on entendra jamais parler des 19 autres qui auront jeté leurs données à la poubelle. Du fait que les revues scientifiques publient les résultats positifs mais rarement les résultats négatifs, il se peut fort bien que pas mal des résultats publiés avec « petit p » juste en dessous du seuil soient en réalité des faux positifs.

Dernière critique que l’on fait souvent à la dictature du « petit p », elle a tendance à exagérer des choses peu intéressantes en pratique. Un p<0,05 ne signifie pas que l’effet est grand, juste qu’il est statistiquement significatif par rapport à la barre d’erreur. Cette confusion est renforcée par le fait qu’en langage courant, le terme « significatif » est synonyme de « grand », alors que ça n’est pas le cas en statistiques. Ainsi un médicament qui fait baisser la tension de 0.01 points en moyenne n’a peut être pas grand intérêt thérapeutique, même si l’effet est bien réel. C’est ce qu’on appelle un résultat « statistiquement significatif » mais « cliniquement non-significatif ».

Bref, quand vous lisez le résultat d’une étude, cherchez le petit p, mais pas seulement lui…Et pour répondre à la question qui donne son titre au billet : souvenez-vous qu’avec le petit p on ne prouve jamais que les résultats soient vrais, juste qu’il est improbable qu’ils soient faux.

L’article de Johnson dans PNAS

Autres billets, ici et ailleurs :

Sur les pièges statistiques : le paradoxe de Simpson

Sur les faux positifs en médecine : Les probabilités conditionnelles

Sur le petit p, un billet récent (et bien plus complet que le mien) chez Freakonometrics

Pour aller plus loin

Une première remarque : l’utilisation du petit p est omniprésente en médecine, sciences sociales, en économétrie et dans certains domaines de la biologie. En revanche, on n’en parle pour ainsi dire jamais en physique. Pourquoi ? Parce qu’en général les expériences sont plus facilement reproductibles. Attention, quand je dis « facilement reproductibles », je ne dis pas que la manip est aisée, mais juste que si vous arrivez à la refaire, il y a de fortes chances d’obtenir les mêmes résultats. En effet en général en physique il y a beaucoup moins de facteurs de variabilité que l’on ne maîtrise pas.

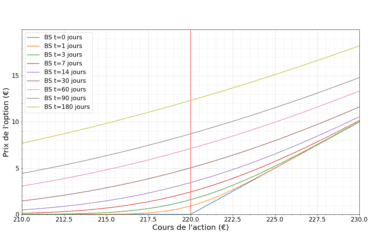

Il y a un domaine qui fait exception : c’est la physique des particules. Au CERN on s’amuse à balancer des particules les unes contre les autres et à observer ce qui se passe, c’est-à-dire à regarder les particules émises par la collision et mesurer leur énergie. C’est un phénomène qui comporte une grande part d’aléatoire et donc il faut faire et refaire des collisions en grand nombre. Ensuite on compare tout ce qu’on a obtenu avec ce que prédit le « modèle standard ». Si dans une certaine gamme d’énergie on obtient un peu plus de signal que ce qu’a prédit la théorie, c’est peut être le signe de l’existence d’une nouvelle particule ! Mais il faut que l’écart soit suffisamment grand pour qu’on ait le droit d’affirmer qu’il y a quelque chose.

Ci-contre on voit un des spectres mesurés dans l’expérience CMS (destinée à trouver le boson de Higgs), avec ce qui attendu selon le modèle standard (pointillés) et ce qui a été mesuré. On voit qu’il y a une bosse autour de 120-125 MeV, mais à l’époque où cette courbe a été publiée, cet excès n’était pas suffisamment élevé pour que les scientifiques aient le droit de clamer une découverte. C’est pour cela qu’il a fallut attendre, et que l’on a enfin entendu il y a quelques mois que les physiciens étaient sûrs « à 99.99% » d’avoir trouvé le boson de Higgs. C’est bien entendu une formulation exagérée, ce que cela signifie c’est que la probabilité que l’excès d’énergie observé à 125 MeV soit un faux positif est de seulement 0.01%. Au passage, on a montré « à 99.99% » qu’il doit exister un nouvelle particule, pas automatiquement que celle-ci soit LE boson attendu.

Ci-contre on voit un des spectres mesurés dans l’expérience CMS (destinée à trouver le boson de Higgs), avec ce qui attendu selon le modèle standard (pointillés) et ce qui a été mesuré. On voit qu’il y a une bosse autour de 120-125 MeV, mais à l’époque où cette courbe a été publiée, cet excès n’était pas suffisamment élevé pour que les scientifiques aient le droit de clamer une découverte. C’est pour cela qu’il a fallut attendre, et que l’on a enfin entendu il y a quelques mois que les physiciens étaient sûrs « à 99.99% » d’avoir trouvé le boson de Higgs. C’est bien entendu une formulation exagérée, ce que cela signifie c’est que la probabilité que l’excès d’énergie observé à 125 MeV soit un faux positif est de seulement 0.01%. Au passage, on a montré « à 99.99% » qu’il doit exister un nouvelle particule, pas automatiquement que celle-ci soit LE boson attendu.

Ensuite, j’ai donné une vision très schématique du petit p, mais il faut bien comprendre que son calcul dépend de la nature des données que l’on regarde et de l’affirmation que l’on considère : c’est tout le domaine des « tests statistiques ». Chaque test (comme le t-test de Student) est en principe adapté dans un contexte donné. Mais le choix du test statistique rajoute aussi un facteur de confusion car il est parfois possible de choisir le test qui nous arrange pour minimiser le petit p.

Il faut comprendre qu’il y a une telle pression sur les chercheurs pour passer ce seuil fatidique de 0.05, que cela peut être très tentant de faire du « hacking » de petit p. Récemment Matthew Hankins a tweeté ce graphique, montrant la distribution des petit p trouvés sur le site de publication Google Scholar. Le fort excès à p=0.05 est bien sûr intrigant voire anormal, et laisse penser que les chercheurs ont « biais » vers cette valeur. Publish or perish…(bon ce graphique n’est pas lui-même une étude scientifique).

Il faut comprendre qu’il y a une telle pression sur les chercheurs pour passer ce seuil fatidique de 0.05, que cela peut être très tentant de faire du « hacking » de petit p. Récemment Matthew Hankins a tweeté ce graphique, montrant la distribution des petit p trouvés sur le site de publication Google Scholar. Le fort excès à p=0.05 est bien sûr intrigant voire anormal, et laisse penser que les chercheurs ont « biais » vers cette valeur. Publish or perish…(bon ce graphique n’est pas lui-même une étude scientifique).

Matthew Hankins a également compilé une liste hilarante des termes que les chercheurs utilisent dans leurs publications pour essayer de faire passer (quand même) des petits p supérieurs à 0.05, du genre « a considerable trend toward significance (p=0.069) », « a strong tendency towards statistical significance (p=0.051) », etc.

Enfin un facteur qui peut justement biaiser l’analyse des petits p, c’est quand on fait soi-même un grand nombre de tests. Reprenons notre exemple de l’influence du gène sur l’hypertension. Si vous testez ainsi 100 gènes différents, même si aucun n’a d’influence réelle, il y en a bien quelques uns qui vont ressortir « par chance » avec un p<0.05. Cela s’appelle faire des comparaisons multiples : en principe dans un article de recherche il faut le mentionner et en conséquence être encore plus exigeant sur le petit p nécessaire pour annoncer sa découverte. Mais qui sait si c’est toujours bien fait.

Je dois avouer que je n’ai pas cherché à comprendre les détails du papier de Johnson. Son idée est de comparer la méthode classique du « petit p » (qui est en essence « fréquentiste ») à une méthode bayésienne. Et il trouve que « en vision bayésienne », un petit p<0.05 paraît bien peu exigeant. Il plaide donc pour l’abaissement des seuils, mais également l’introduction de méthodes bayésiennes dans les évaluations statistiques.

De manière amusante, la physique des particules fait un petit peu du bayésien, puisqu’on considère que pour annoncer un nouveau phénomène, il faut « 5 sigmas », mais pour le confirmer, 3 sigmas suffisent. Donc on prend bien en compte le prior.

Encore des références :

Sur les fréquentistes et les bayésiens : l’argument du Doomsday (et des chars allemands)

Pierre Barthélémy a parlé du papier de Johnson, et le débat en commentaire est intéressant. Le pauvre Pierre est attaqué par des chercheurs pour oser jeter le discrédit sur la science.

24 Comments

Car il est vrai que quand on cherche, on finit bien par trouver … http://xkcd.com/882/

Nous parlons donc du risque de fausse conclusion à partir de données déterminées. Dans le deuxiéme exemple s´ajoute un autre facteur de risque de fausse conclusion parce que le groupe possédant le géne peut aussi posséder d´autres caractéristiques (une seule ou plusieurs provenant de facteurs environementals tels que l´alimentation ou le stress ou le physique personnel, etc…) qui provoquent l´hypertension et qui sont connues ou pas, mais dont on ne tient pas compte. Et le gène pourrait n¨^eter responsable qu´à 20 ou 30 %. Une autre ou plusieurs autres caractéristiques seraient plus responsables que le gène en question.

Il serit intéressant d´expliquer comment on calcule la valeur de ce petit p.

Oui bien sûr j’ai simplifié, il y a toujours plein de manière de se tromper !!

Pour le calcul du petit p, ça dépend du contexte et des hypothèses du test statistique. Mais très grossièrement (pour le t-test) on peut s’amuser à calculer

$latex \frac{\sqrt{N}\Delta \mu}{\sigma}$ et à regarder l’intégrale de la gaussienne pour toutes les valeurs supérieures à cela.

Très bonne présentation du « petit p », c’est je pense très clair pour quelqu’un qui n’en a jamais entendu parler donc bravo! A faire lire aux étudiants en intro des cours de stats !

Merci ! Si c’est très clair alors l’objectif est atteint 🙂

Tout à fait un article très clair et qui serait utile dans tous les articles sur l’homéopathie, à commencer tout dernièrement ici http://pourquoilecielestbleu.cafe-sciences.org/articles/les-homeopathes-se-revoltent-contre-boiron/#comment-48078 .

Par contre je suis déçu, je comptais sur toi pour me prémâcher le travail sur la comparaison modèle bayésien / modèle classique. Juste une ligne sniff…

Pour info, Psychological Science revoit ses règles de soumission en matière de stats pour janvier 2014, incluant des stats bayésiennes http://pss.sagepub.com/content/early/2013/11/07/0956797613504966.full Ca commence à bouger !

Je pinaille sur une formulation un peu vague qui laisse la place à une interprétation fausse et courante : « Souvenez-vous qu’avec le petit p on ne prouve jamais que les résultats soient vrais, juste qu’il est improbable qu’ils soient faux. »

Ou plutôt : s’ils sont faux alors les scientifiques n’ont vraiment pas eu de chance avec leur expérience. Les résultats eux-mêmes sont vrais ou faux, il n’y a pas de probabilité ici :-).

Très bon article que je conseillerai à tous les prochains novices en stat que je croiserai.

Et je suis tout à fait d’accord avec le fait de prendre des gants avec ce p.

Cependant, outre le fait que les chercheurs sont obnubilés par la valeur de ce p et peuvent chercher à ce qu’il soit en dessous du seuil fatidique et néanmoins arbitraire des 5% (selon la discipline le seuil est bien inférieur à 5% comme par exemple dans le domaine du biomédical), il y a un autre facteur à prendre en compte dans les résultats donnés par les revues scientifiques: les compétences en statistique des chercheurs. En effet, les chercheurs, quelque soit leur discipline de prédilection, peuvent être excellent dans leur domaine, mais il reste qu’ils ne sont pas statisticiens, les statistiques étant une discipline à par entière. Donc, parfois (peut-être souvent, je ne sais pas), le choix d’un test potentiellement mal adapté aux données et/ou à la question posée, peut tout simplement être du à la méconnaissance, sans pour autant que cela soit volontaire. Et j’ai bien peur que l’entrée des statistiques bayesiennes par la grande porte et leur obligation pour pouvoir publier (si jamais ça arrive), induise bien plus d’erreurs qu’il n’existe déjà dans les résultats publiés, étant donné la « complexité » (tout est relatif) qu’elles semblent représenter pour le plus grand nombre.

Parfois on gagne à rester sobre et à prendre des gants en concluant, plutôt qu’à vouloir être toujours plus pointilleux et à finalement noyer les matelots du navire.

Petite remarque: avec tous les résultats qui sont publiés, un moyen de démêler le vrai du faux (ou plutôt de savoir qui a le plus raison quand des résultats contraires sont publiés) est la méta-analyse. Cette méthode est une des plus redoutable pour avoir un échantillonnage le plus grand possible et difficilement atteignable par une seule équipe de recherche 🙂

« souvenez-vous qu’avec le petit p on ne prouve jamais que les résultats soient vrais, juste qu’il est improbable qu’ils soient faux. »

Dans cette étude, il est montré que le degré du vrai scientifique dépend prioritairement du succès de la répétition des expériences. C’est Descartes qui va être content…

La science n’est que la réalité de ses outils ; sans eux, elle est mort-née. J’affirme avec un petit p défiant toute concurrence que la science est apparue aux êtres grâce à leur perception extérieure qui a permis la destination des objets. Aussi incroyable que cela puisse paraître, il convient de dire que la science n’est pas d’origine humaine ; car un simple oiseau en façonnant un nid est un expérimentateur ; et en cela, il a une démarche scientifique. En ce qui concerne la branche humaine, les avancées scientifiques sont dues essentiellement au formidable développement des outils théoriques ou expérimentaux mis à sa disposition. Étonnement, ce perfectionnement a la double fonction d’élargir les domaines d’étude tout en réduisant les possibles.

Bien à vous…

Pingback: Comment être sûr qu’un r&eacu...

Pingback: Comment être sûr qu'un résul...

Le meilleur moyen de commettre une erreur(de se tromper),est de se croire plus fin que les autres.L’assurance ne protège pas toujours l’assuré;quelle est le petit p pour un passion sur la table d’un bloc chirurgical?

Jeune statisticien j’avais aboutit intuitivement vers cette conclusion de Valen Johnson, mais pas seulement pour cette raison mais aussi pour la modélisation statistique préalable à l’obtention de ce « petit p ». Concernant le bayésien et fréquentiste il y a une différence de philosophie mais aussi légèrement de calculs, http://www.laeuferpaar.de/Papers/LindleyPSA.pdf est un bon début, http://en.wikipedia.org/wiki/Lindley%27s_paradox .

Je n’ai plus les idées assez claire pour expliquer le tout proprement mais si il y a des intéressés et des questions je pourrais faire un effort.

Voici une illustration sympa de ce problème : http://xkcd.com/882/

Pingback: Les homophobes sont-ils des homosexuels refoulés ? | Science étonnante

En terme statistique on ne parle pas de « petit p » mais de p-value. Ca fait déjà plus pro. Et pour être vraiment complet sur la question, normalement si les chercheurs faisaient bien leur travail ils calculeraient ce que l’on appelle la « puissance du test », variant entre 0 et 1. Il est généralement admis dans les cercles autorisés que le résultat d’un test d’hypothèse est satisfaisant si la puissance du test est >0,8. Ainsi, si la p-value est de 0,01 (youpi!), mais la puissance de test de 0,5 on aurait une chance sur deux de se tromper. Cependant il n’est pas toujours aisé de calculer la puissance du test.

Bonjour David.

Question:Lors de la mesure de la taille des femmes; est-ce qu’elles portaient des talons haut? Ce n’est pas mentionné. 🙂

Pingback: Glyphosate : le nouvel amiante ? | Science étonnante

Pingback: Comment lire une étude scientifique ? | Science étonnante

On a des cours de stats assez basiques à la fac où on parle de la fameuse valeur p (Corrélation linéaire : Khi² et Bravais-Pearson). Qu’on met arbitrairement à 0.05, mais qu’on descend au minimum dès qu’on en a la possibilité.

Ça serait intéressant d’avoir une méthodo pour trouver quelle valeur p doit prendre selon le type d’exercice…

Si non, je note qu’il y a eu du recyclage de cet article dans la dernière vidéo YouTube 😛

Très bon article !

Lorsqu’on a mené une étude pendant une longue période, nous avons vraiment envie de montrer qu’un facteur induit une différence significative. Or, lorsque nous avons cette p-value très proche de 5 %, il faut redoubler d’attention ! Remanier ses données pour voir si on arrive à la même conclusion et ne pas crier victoire trop vite.

Je suis d’accord avec « La dictature du « petit p » ». On y attache toute son importance au détriment des hypothèses préalables, paramètres de tests etc … C’est peut-être pour cela que l’on voit sur les réseaux sociaux des « études » qui prouvent tout et leurs contraires. Sans parler de la confusion corrélation/causalité …

A reblogué ceci sur Le magazine en ligne de la Fondation littéraire Fleur de Lys.

Tres bonne présentation du petit p, très facile a comprendre même pour les profanes du domaine.

merci

Pour neutraliser le problème évoqué par Valen Johnson, une solution ne serait-elle pas de ne publier que les études à p<5%, issues d’un groupe (à protocole identique) dont la moyenne des valeurs p est inférieure à 5 % ?