Vous venez de passer un test pour le dépistage du cancer. Le médecin vous convoque pour vous annoncer le résultat : mauvaise nouvelle, il est positif. Pas de chance, alors que ce type de cancer ne touche que 0.1% de la population.

Vous venez de passer un test pour le dépistage du cancer. Le médecin vous convoque pour vous annoncer le résultat : mauvaise nouvelle, il est positif. Pas de chance, alors que ce type de cancer ne touche que 0.1% de la population.

Vous demandez alors au praticien si le test est fiable. Sa réponse est sans appel : « Si vous avez le cancer, le test sera positif dans 90% des cas ; alors que si vous ne l’avez pas, il sera négatif dans 97% des cas ». L’affaire paraît entendue…

Et pourtant, à votre avis, après le résultat d’un tel test, quelle est la probabilité que vous ayez le cancer ? 90% ? 87% ? Moins que ça ?

Pour répondre à cette question, il va falloir faire un tout petit peu de probabilités…mais ça en vaut la peine, vous allez découvrir que malgré votre test positif, la probabilité d’être malade n’est que de 2.9% ! Creusons un peu ce petit paradoxe, et partons à la découverte de la formule de Bayes, l’une des plus importantes de toute l’histoire des sciences !

Le calcul facile

Le calcul facile

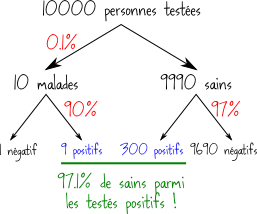

Si on pose correctement les choses, vous allez voir que le calcul est en fait très facile. Imaginons que 10 000 personnes viennent passer le test. Puisque le cancer en question touche 0.1% de la population, il y aura 10 malades parmi ces 10 000 patients. Et comme le test a une efficacité de 90% sur les malades, 9 de ces malades seront testés positivement.

Considérons maintenant ceux qui n’ont pas ce cancer : ils sont 9990. Puisque dans 97% des cas le test donne un résultat négatif chez une personne saine, il y aura environ 9690 tests négatifs, et donc 300 tests positifs chez ces 9990 personnes saines. Le bilan de cette petite analyse est représenté sur le schéma ci-contre.

Morale de l’histoire, sur les 309 personnes qui sont testées positives, 9 seulement sont réellement malades, et 300 sont saines : ces 300 sont ce qu’on appelle des faux positifs. Si vous êtes positif, vous n’avez donc que 9/309 = 2.9% de risque d’être réellement malade, et 97.1% de chance d’être un faux positif, et donc d’être sain. Contre-intuitif, non ?

Pourquoi le résultat est-il contre-intuitif ?

Si vous pensiez avoir une probabilité élevée d’être malade, et si vous êtes perplexes devant ce résultat de seulement 2.9% : rassurez vous, vous n’êtes pas les seuls ! Quand une question de ce genre est présentée à des médecins, une écrasante majorité d’entre eux se trompent lourdement, et donnent des réponses du genre 90% ! Donc même pour des professionnels, ce paradoxe des probabilités est bien difficile à dompter.

Si vous avez répondu 90%, vous avez commis une erreur classique, mais pas si simple à appréhender. Voyons ensemble : si vous êtes testé positif et que vous vous demandez si vous avez le cancer, vous cherchez « la probabilité d’être malade sachant que le test est positif ». Mais quand le médecin vous dit que « Si vous avez le cancer, le test sera positif dans 90% des cas », il vous parle de « la probabilité d’être testé positif sachant que l’on est malade ». Vous saisissez la différence entre les deux ?

Autre source d’erreur classique, sous-estimer la possibilité de faire partie des faux positifs. Dans ce test, les sains apparaitront négatifs dans 97% des cas, mais positifs dans les 3% restants : ce sont les faux positifs. Intuitivement quand on considère ce chiffre de 3%, on se dit que c’est très faible et qu’on n’en fait certainement pas partie. Mais on se trompe, car quand la maladie est globalement rare (ici 0.1%), la probabilité d’être dans les faux positifs est beaucoup plus importante.

J’espère que vous êtes maintenant convaincus que malgré le test positif, vous êtes très certainement sain. Mais pour creuser plus loin les causes mathématiques de ce raisonnement, il va falloir s’intéresser à ce qu’on appelle les probabilités conditionnelles. Nous en avons déjà fait depuis le début de ce billet, puisque ce terme désigne les probabilités dès que l’on utilise l’expression « sachant que ».

Rappels de probabilités

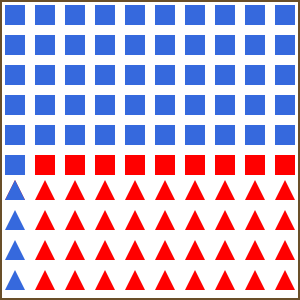

Pour apprendre les probabilités, il est de coutume d’utiliser une urne remplie d’objets, et de faire des tirages au hasard dedans. Imaginons donc une urne qui contient 100 objets, pouvant avoir deux formes (carré ou triangle) et deux couleurs (bleu ou rouge). La composition détaillée de l’urne est donnée sur le dessin ci-contre.

Pour apprendre les probabilités, il est de coutume d’utiliser une urne remplie d’objets, et de faire des tirages au hasard dedans. Imaginons donc une urne qui contient 100 objets, pouvant avoir deux formes (carré ou triangle) et deux couleurs (bleu ou rouge). La composition détaillée de l’urne est donnée sur le dessin ci-contre.

Une main innocente tire un objet au hasard, quel est la probabilité que ce soit un carré ? Facile ! Il y a 100 objets, 60 sont des carrés, donc la réponse est 60%. Jusqu’ici tout va bien.

Imaginez maintenant que la main innocente tire un objet, et que vous parveniez à distinguer rapidement que cet objet est rouge. Quel est la probabilité que ce soit un carré ? Facile aussi, il y a 45 objets rouges, dont 9 qui sont à la fois rouges et carrés, la « probabilité d’être un carré sachant qu’il est rouge » est donc 9/45 = 20%.

Si vous comparez ces deux situations, vous constatez que la probabilité que l’objet soit un carré est fortement affectée par le fait de savoir qu’il est rouge. La « probabilité que l’objet soit carré » n’est pas la même que la « probabilité que l’objet soit carré sachant qu’il est rouge ».

Les mathématiciens parlent de probabilités « conditionnelles », et utilisent la barre verticale | pour symboliser l’expression « sachant que ». Dans les exemples précédents, on a donc

P(Carré) = 60%

P(Carré | Rouge) = 20%

Maintenant je vous invite à faire le calcul inverse. Vous tirez un objet les yeux bandés, vous sentez dans votre main qu’il est carré : quel est la probabilité qu’il soit rouge ? Si vous regardez attentivement la composition de l’urne, il y a 60 objets carrés, dont 9 qui sont rouges, donc

P(Rouge | Carré ) = 9/60 = 15%

Une leçon importante dans cette affaire, c’est que P(Rouge | Carré ) n’est pas la même chose que P(Carré | Rouge).

Nous avons vu dans notre exemple du cancer que notre erreur venait justement de la confusion entre P(Malade | Positif) et P(Positif | Malade). Il est donc important de pouvoir passer de l’un à l’autre dans un calcul. Et comment connaître P(B|A) si on connait P(A|B) ?

C’est là qu’intervient une formule découverte par le révérend Thomas Bayes au XVIIIème siècle, mais qui – hasard de la science – n’a été publiée qu’après sa mort.

La formule de Bayes

Si vous reprenez le calcul précédent, dans le cas où l’on sait que l’objet est rouge, on calcule la probabilité d’être carré en divisant le nombre d’objets carrés et rouges par le nombre total d’objets rouges. On a donc

P(Carré | Rouge) = P(Carré et Rouge) / P(Rouge)

Mais on peut également permuter les rôles des formes et des couleurs, et écrire

P(Rouge| Carré) = P(Carré et Rouge) / P(Carré)

En regroupant les deux formules et en éliminant P(Carré et Rouge), on a

P(Carré | Rouge) = P(Rouge| Carré)P(Carré)/P(Rouge)

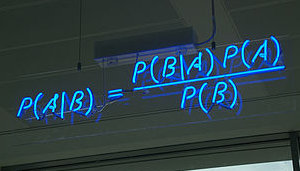

Thomas Bayes avait observé que cette formule est vraie en général, et pas seulement pour notre problème d’objets carrés et rouges dans une urne. La célèbre formule de Bayes s’écrit sous sa forme abstraite

\(P(A|B) = \frac{P(B|A)P(A)}{P(B)}\)

où A et B sont des évènements quelconques. Prenez un peu de temps pour la contempler, il s’agit bien d’une des formules les plus importantes de toute l’histoire des sciences !

Si vous l’appliquez au problème du cancer, vous obtenez

\(P(C|+) = \frac{P(+|C)P(C)}{P(+)}\)

Et vous pouvez vérifier que ça fonctionne !

Maintenant que vous connaissez la formule de Bayes, vous êtes prêts à découvrir tout un monde de raisonnements nouveaux ! Ce sera pour la prochaine fois, mais pour vous mettre l’eau à la bouche, nous verrons le rapport entre la formule de Bayes, la recherche du coupable lors d’une enquête, la détection du spam, mais aussi cette incroyable illusion d’optique

[youtube=http://www.youtube.com/watch?v=QbKw0_v2clo]

71 Comments

Pingback: Les probabilités conditionnelles (Bayes level 1) | Mathoscoopie | Scoop.it

Merci pour l’article. En remerciement, une correction : « une écrasante majorité d’entre eux se trompent lourdement ». Non : la majorité, non seulement c’est une fille, mais en plus elle est toute seule 😉 !

La langue française est malheureusement (heureusement ?) plus complexe que cela :

http://www.larousse.com/en/dictionnaires/francais/majorit%C3%A9/48777/difficulte

http://66.46.185.79/bdl/gabarit_bdl.asp?id=1682

Je pense qu’il est correct ici d’utiliser le pluriel car on veut insister sur la pluralité.

Merci c’est bien ce que je voulais faire !!

Oh, et bien décidément, en plus de cette jolie synthèse sur les probas conditionnelles, vous m’apprenez une richesse supplémentaire de notre belle langue, double merci 😉 !

En fait, « la majorité » ne peut pas se tromper, ce sont les gens qui se trompent, d’où l’accord au pluriel.

Pour moi, une façon de « voir » le problème, c’est de prendre des cas limites. Si la probabilité d’être malade est très très très très faible (10^-beaucoup) alors même avec un très bon test, on ne verra que des faux positifs. Tout simplement parce que le praticien a plus de chance de gagner au loto 10 fois de suite que de tomber sur un malade.

Pingback: Les probabilités conditionnelles (Bayes level 1) | C@fé des Sciences | Scoop.it

Mais dis-donc, ce n’est plus un article, c’est un cours ! Et en plus, il m’intéresse ! Bravo.

merci beaucoup ! cela m’a pris beaucoup de temps mais c’était un vrai plaisir de partager mes passions

« il y aura environ 3690 tests négatifs, et donc 300 tests positifs chez ces 9900 personnes saines. »

Coquille sur 3690?

Sinon tres bel article une nouvelle fois.

» il y aura environ ****3690**** tests négatifs, et donc 300 tests positifs chez ces 9900 personnes saines »

Je suppose que vous vouliez dire 9690 :o)

oui ah ah désolé ! j’espere que ca ira pour vous

A jans et Kwak-kwak : merci pour le relevé de la coquille, c’est corrigé !

Pingback: Les probabilités conditionnelles (Bayes level 1) | Autour des maths | Scoop.it

Merci beaucoup pour cet exposé très clair. Simplement, on pourrait rajouter que « la probabilité d’être malade sachant que le test est positif » correspond à la valeur prédictive positive de celui-ci (et que celle-ci varie en fonction de la prévalence de la maladie, ce que vous montrez bien). Et le médecin répond parfois à tord en prenant des chiffres de sensibilité ou spécificité correspondant à la probabilité d’avoir un test positif/négatif lorsque l’on connait le statut du patient vis à vis de la maladie (présente/absente), ce qui n’est pas le cas dans la pratique clinique: on fait un test pour connaitre le statut du patient vis à vis de sa maladie. Enfin, pour les tests de dépistage, l’importance clinique est de ne pas laissé passer de malade: il doit y avoir très peu de faux négatifs. Par contre il y a souvent plus de faux positifs, ce qui n’est pas grave puisque ce test de dépistage ne conclut pas au cancer mais permet de décider de réaliser des investigations complémentaires.

« Et le médecin répond parfois à tord en prenant des chiffres de sensibilité ou spécificité correspondant à la probabilité d’avoir un test positif/négatif lorsque l’on connait le statut du patient vis à vis de la maladie (présente/absente) »

Ben oui, il tort la vérité 😉

Merci pour l’article, toujours intéressant. Sinon l’application de la formule finale n’est pas si facile, il faut calculer P(+)…

Ah oui j’aurai dû être plus précis là-dessus.

La bonne manière est la suivante :

P(+) = P(+ et C) + P(+ et non-C) = P(+ | C) P(C) + P(+ | non-C) P(non-C)

Ce qui revient à faire le calcul présenté initialement dans mon graphique.

Il y a aussi des cas où on a pas besoin de calculer P(+), notamment quand on cherche à maximiser une expression du type P( x | A) où x est une variable continue. Alors on a juste à dériver et chercher le zero; et la valeur de P(A) est juste une constante sans importance.

Merci beaucoup pour cet article qui met les probabilités à la portée d’un plus grand nombre. Néanmoins pas sûr d’être capable de refaire la démonstration sans ce support ! Très bien écrit, très bien expliqué.

Marie AMOROSINI

Effet Papill’or

Puis-je me permettre de vous conseiller la lecture de « Penser le risque » de Gerd Gigerenzer, éditions Markus Haller, 2009, qui analyse en détail la situation présentée au début de cet excellent article (et bien d’autres chses encore …). Ce livre est passionnant, très clair et accessible à des non-matheux.

Merci, Alain ! Et voici le lien : http://www.markushaller.com/livre/id/4/Gerd+Gigerenzer+Penser+le+risque

Ce qui est toujours étonnant, c’est de voir à quel point ces problèmes de probabilité conditionnelle sont contre-intuitifs, alors qu’ils sont à la base même de nos processus d’apprentissage naturels (mais je ne veux pas jouer les spoilers 😉 )

Heu … qu’est-ce que ça veut dire « jouer les spoilers » ?

Ca veut dire que Xochipilli et moi avons les mêmes lectures ! La suite de l’article (Bayes level 2) sort ce soir !

Pingback: L’inférence bayésienne (Bayes level 2) « Science étonnante

Belle découverte, j’étais certain que les mathématiques ouvraient un monde plus magique que celui des formes usuelles de dérivation avalées au lycée !

Juste une remarque, quand tu présentes la formule suivante : P(Carré | Rouge) = P(Carré et Rouge) / P(Rouge), ne serait-ce pas plus juste si P(Carré et Rouge) et P(Rouge) prenaient la forme de N(Carré Rouge) et N(Rouge) rapportés respectivement au nombre de carrés rouges et au nombre de symboles rouges.

Tu le dis d’ailleurs en mots (« on calcule la probabilité d’être carré en divisant le nombre d’objets carrés et rouges par le nombre total d’objets rouges »), alors je pose finalement la question pour savoir si ton énoncé et ta formule sont tous les deux vrais.

Merci d’avance,

Nicolassss.

Très très bonne remarque. Pour être honnête, j’ai hésité à l’écrire exactement comme ça, c’est-à-dire avec N(Carré et Rouge)/N(rouge), puis à expliquer qu’en divisant en haut et en bas par le nombre total d’éléments, ça donne P(Carré et Rouge)/P(rouge)…et puis…je ne sais pas pourquoi je ne l’ai pas expliqué comme ça !

Mélange de flemme de détailler, de peur que ça rallonge trop, et de me dire « bah ils comprendront bien comme ça ». Oui je sais c’est pas bien :-(, il ne faudrait jamais relâcher les standards pédagogiques !! Merci de la question qui m’a permis de me rattraper !

C’est surtout, qu’il faudrait, par honnêteté intellectuelle, rappeler que le calcul des probabilités ne se réduit pas à de simples calculs de proportions et qu’une probabilité s’exprime rarement en pourcentage puisque c’est un nombre compris entre 0 et 1. Cela dit l’exemple présenté ici satisfait les liens qui unissent probabilité et proportion, et permet d’illustrer la formule de Bayes et aussi ce qui en découle et qui constitue le théorème de la probabilité totale. N’oublions pas que les paradoxes, et donc leurs corollaires qui constituent des sources de confusion, ont souvent pour origine des raccourcis, des approximations ou des libertés (consenties ou pas) dans les énoncés des problèmes et de leurs solutions.

Donc, en conclusion, je dirais, vulgarisation : oui, mais minimum de rigueur : oui aussi.

http://www.eyrolles.com/Sciences/Livre/modelisation-probabiliste-pour-l-ingenieur-9782729852764

Bonjour.

Je souhaiterai un petit éclaircissement quant au petit calcul de probabilité.

« Morale de l’histoire, sur les 309 personnes qui sont testées positives, 9 seulement sont réellement malades, et 300 sont saines »

-Ne serait-il pas plus juste de dire que 309 personnes sont réellement positives et que 9 ont été dépisté?

» ces 300 sont ce qu’on appelle des faux positifs. »

-Et donc, 300 faux négatifs.

« Si vous êtes positif, vous n’avez donc que 9/309 = 2.9% de risque d’être réellement malade, et 97.1% de chance d’être un faux positif, et donc d’être sain. »

-Si vous êtes *testé* positif, vous avez donc 9/10 = 90% de risque d’être réellement malade. 97.1% de personnes réellement positives sur les 10000.

Merci de me corrigé si je suis à côté de la plaque, je ne suis qu’un néophyte en probabilité.

Pardon je corrige mon dernier commentaire:

« 97.1% de personnes saines sur les 10000 testées. »

Chaque fois que j’écris positif, il faut bien entendre « testé positif », c’est à dire que le fait d’être « positif » ne fait référence qu’au résultat du test, pas au fait d’être malade ou non. Désolé si je n’ai pas été clair là dessus.

Tombé par hasard sur un recueil de blagues baysiennes : http://www2.isye.gatech.edu/~brani/isyebayes/jokes.html

Pingback: C’est mathématique. « sfnum-e-theque

Aussi seduisante qu’apparait cette demonstration, je n’arrive malheureusement pas a me convaincre, en particulier, de l’utilite d’y incorporer le fait que 0.1% de la population soit touche par ce type de cancer. En effet, intuitivement, je ressens que les resultats des tests de sensibilite sont « independants » de la notion du pourcentage de gens affectes par la maladie. Dans ma tete, on effectue les tests sur une meme proportion de personnes malades et personnes saines (par exemple 50 / 50), En serait-il different ? Et si tel est le cas, le raisonnement s’appliquerait-il differemment ?

Oui l’intuition est parfois difficile à combattre ! Le mieux pour ça, c’est de prendre des cas extrèmes. Imaginez que la maladie touche 0.0000001% de la population (soit seulement 7 personnes sur Terre) et que le taux de faux positifs soit 40%. Si vous êtes positif au test, vous devriez vous convaincre facilement que vous n’êtes très certainement pas atteint, mais plutôt un faux positif.

Et si nous n’avions aucune estimation sur le taux de cancer pour la population, que pourrions-nous conclure a un resultat positif du test ?

Nous pourrions juste en déduire que la probabilité d’avoir un cancer est plus élevée que avant de faire le test, mais pas de combien. Avant le test, la probabilité était P(C), après le test positif, cette probabilité de base est multipliée par P(+/C) (sensibilité du test) / P(+), hors P(+) est nécessairement inférieur à P(+/C)

Vous avez raison sur au moins un point, Ericdes : la sensibilité (comme la spécificité) est une caractéristique du test qui est dite « intrinsèque », c’est à dire qu’elle ne dépend pas de la population dans laquelle est appliquée ce test. Dans l’exemple du haut de l’article, si vous appliquez le test à 100 personnes atteintes de la maladie, vous aurez (en moyenne) 90 résultats positifs, et si vous l’appliquez à 100 personnes indemnes vous aurez 97 résultats négatifs. En revanche, les Valeurs Prédictives (Positive ou Négative, donc VPP et VPN) qui sont celles qui nous intéressent lorsqu’on applique le test dans la vraie vie sont, elles, dépendantes de la fréquence de la maladie testée dans cette population.

En tant que médecin généraliste, enseignant, il est primordial pour moi de connaître l’ordre de grandeur de la fréquence de la maladie testée dans la population que je teste, pour connaître la valeur du test dans ma pratique. Un exemple admirable en est donné dans ce document : http://lmm.univ-lyon1.fr/internat/download/item%2072%20b.pdf, qui montre de quelle façon le même test, appliqué à des patients présentant la même plainte, va avoir une utilité très différente s’il est pratiqué dans un cabinet de rhumatologue (où le test permettra de dire qu’il y a 1 « chance » (en l’occurrence, plutôt une « malchance ») sur 2 que le patient soit atteint de la maladie que l’on recherche) ou bien dans un cabinet de médecin généraliste ou cette fois le patient aura 1 chance sur 10 seulement d’avoir cette maladie.

J’ai une application pratique de cette différence dans mon exercice quotidien, que je cite souvent à mes étudiants. J’assure également une vacation dans un service hospitalier où je reçois des migraineux. Si je reçois un patient avec des signes cliniques de migraine légèrement inhabituel dans ce service, je vais lui demander une IRM du cerveau, parce que les gens qui vont jusqu’à venir consulter à l’hôpital dans un service spécialisé ont un risque plus élevé que leur migraine soit secondaire à une maladie du cerveau. Si je reçois EXACTEMENT le même patient à mon cabinet, je ne vais pas lui prescrire (en tous cas PAS d’EMBLEE – je pourrais le faire s’il y a d’autres signes plus inquiétants ou bien si la maladie ne répond pas au traitement comme elle le devrait) cet examen, parce que les patients qui vont consulter un généraliste pour migraine ont un risque vraiment infime que cette migraine soit due à une maladie du cerveau. Donc, si je prescris à tous les patients qui sont dans cette catégorie une IRM, je vais « peut-être » une fois dans toute ma carrière découvrir précocement une maladie du cerveau, mais la plupart du temps j’aurais occasionné une inquiétude sans fondement à des patients qui n’en ont pas besoin pour être traités.

Pingback: news | Pearltrees

Pingback: Le paradoxe de Simpson | Science étonnante

« Puisque le cancer en question touche 0.1% de la population, il y aura 10 malades parmi ces 10 000 patients. Et comme le test a une efficacité de 90% sur les malades, 9 de ces malades seront testés positivement. »

Ça pourrait être faussé par la population qui vient se faire tester: on vient plus souvent se faire tester quand on a un doute, donc parmi cette population, il y aura très probablement un pourcentage plus élevé de personnes touchées par le virus !

Merci pour ce article ça m’a beaucoup aidé

Pingback: 78: Comment convaincre par les maths • Neuromonaco

Pingback: Comment être sûr qu’un résultat scientifique est vrai ? | Science étonnante

Pingback: Valeur prédictive d’un test de dépistage – Ou comment un test avec une précision de 90% peut générer un résultat positif qui a 68% de chances d’être faux | Coffee break science

Faux positifs :

Une bonne part des problèmes soulevés autour de cette affaire vient du choix fait en médecine de la définition des faux positifs. Spontanément, quand on vous parle de faux positifs chacun visualise les positifs au test et sélectionne les faux (les non malades) parmi eux. Réaction on ne peut plus normale. Plus précisément on cherche la probabilité P(nM si T) c’est à dire la probabilité de ne pas être malade si positif.

Mais la médecine a préférer prendre P(T si nM), la probabilité d’être positif si on n’est pas malade comme indicateur pouvant aider à caractériser les propriétés du test. Or c’est un très mauvais indicateur car sa valeur va dépendre de la population considérée.

Prenons l’exemple du taux de PSA pour la prostate. Si on inclut les hommes de 20 ans, le test sera toujours négatif pour eux et ils n’auront pas de problème de prostate. Se pose alors la définition de la population à considérer : des hommes et pas des femmes, oui sans doute mais à partir de quel âge ? 50 ans, 55, 58, 60 … ? Selon ce choix, la valeur de l’indicateur pourra changer notablement. On voit qu’un tel indicateur est élastique, donc manipulable volontairement ou involontairement.

Par contre, la première définition P(nM si T) donne un indicateur beaucoup plus fiable car la définition élimine tous ceux qui seront négatifs au test comme les hommes jeunes par exemple ou les femmes.

Que l’on puisse rencontrer P(T si nM) dans les calculs est une chose mais qu’on ait choisi cette valeur comme indicateur, c’est à dire choisi de la nommer et de l’encadrer en quelque sorte, est un très mauvais choix qui conduit à toutes sortes de difficultés inutiles comme de piéger les étudiants en médecine aux examens, puis plus tard, devenus grands, les médecins eux-mêmes et leurs patients. Ceux qui ont compris le piège, pensant alors avoir soudain compris quelque chose aux mathématiques et aux probabilités, croient ainsi faire partie des rares initiés quand le vulgaire resterait encore imprégné par la définition spontanée qui, une fois n’est pas coutume, est la seule valable en tant qu’indicateur.

Toute l’affaire repose donc sur un choix initial malheureux de la définition des faux positifs, d’autant plus regrettable que l’autre définition, la bonne, est fort heureusement utilisée dans d’autres disciplines, ce qui ne peut qu’ajouter à la confusion. Mais qui a créé la confusion ?

« Si la probabilité d’être malade est très très très très faible (10^-beaucoup) alors même avec un très bon test, on ne verra que des faux positifs. Tout simplement parce que le praticien a plus de chance de gagner au loto 10 fois de suite que de tomber sur un malade. » dit Mazoit qui met ainsi le doigt sur un autre aspect du problème.

En fait le praticien ne tire pas au hasard un échantillon représentatif dans la population. Dans le cas d’une maladie rare et grave les malades sont pratiquement tous connus. On peut alors les tester tous. On cherche ensuite à évaluer la prévalence qui demande d’abord de définir la population à considérer comme dans le cas du taux de PSA pour la prostate ou d’un test de grossesse. Ce n’est pas si simple qu’il y parait car il y a une certaine indétermination.

Il restera encore à évaluer la probabilité d’être négatif au test sachant qu’on n’est pas malade et donc à prendre un échantillon adéquat de non malades qui devra donc correspondre à la population choisie pour obtenir la prévalence. On testera alors tous les membres de cet échantillon qui ne devra pas être trop important pour ce faire. Ces 3 nombres seront alors utilisés dans le formule de Bayes mais dans un contexte hors du cadre du calcul des probabilités qui demanderait de choisir un échantillon aléatoire, d’en tester tous les membres puis de rechercher les positifs et les malades. On obtiendrait alors immédiatement une évaluation de la probabilité P(M si T), la probabilité d’être malade si positif, sans avoir besoin d’utiliser Bayes. C’est cette impossibilité de pouvoir obtenir un tel échantillon de taille raisonnable pour pouvoir tester tous ses membres tout en y trouvant suffisamment de malades qui contraint à utiliser Bayes dans une situation hors cadre de la théorie, en estimant les 3 valeurs nécessaires, P(T si M), P(M) et P(T si nM)=1-P(nT si nM) sur 3 échantillons indépendants, de natures et de tailles très différentes. D’où des problèmes comme signalés par exemple sur ce lien :

http://www.jle.com/e-docs/00/03/0D/50/article.phtml

« En dehors des situations de dépistage, il est préférable d’évaluer la qualité d’un test diagnostique dans une population à risque (où la prévalence de la maladie est élevée). Ceci explique qu’un test dont la valeur diagnostique a été évaluée en milieu hospitalier puisse perdre ses qualités prédictives lorsqu’il est utilisé à plus grande échelle. La modification des valeurs prédictives par la prévalence est à l’origine de l’erreur commise dans une étude de type cas/témoins, où le clinicien évalue le test sur un groupe de n malades et n sujets sains. On peut certes calculer la sensibilité et la spécificité du test, mais les valeurs prédictives obtenues sont fausses parce que le type de l’étude prenant les mêmes effectifs de cas et de témoins fixe artificiellement la prévalence de la maladie à 50 %. »

Vous voyez que l’affaire est très loin d’être simple en pratique

Pingback: Le test de Turing-Parker : un ordinateur peut-il improviser comme Charlie Parker ? | Science étonnante

A reblogué ceci sur Partager pour Comprendreet a ajouté:

En son temps, et pour compléter (ou éclaircir) un aspect d’un article sur l’évaluation des risques technologiques ou naturels, j’avais ajouté à mon blog « Partager pour comprendre » une page sur le théorème de Bayes. Mais, comparée à la contribution que je viens de découvrir dans « Science étonnante », elle fait pâle figure. C’est pourquoi je suis très heureux de vous donner l’opportunité de découvrir les lumineuses explications données dans « Science étonnante » à propos « d’une des plus importantes formules de l’histoire des sciences ». Bravo !

Pingback: Twittez aux sénateurs le calcul des effets probables du #PJLRenseignement contre la menace terroriste | leclown

Tiens, il semblerait que les préconisations en matière de dépistage du cancer du sein prennent prochainement en compte les résultats donnés par l’équation de Bayes… http://www.ledauphine.com/sante/2016/10/03/le-depistage-du-cancer-du-sein-sera-renove

Pingback: Article 5 la renaissance du temps Partie II chap. 12 (la mécanique quantique et la libération de l’atome) | Thomassonjeanmicl's Blog

Pingback: La loi de Bayes — Argument frappant #3 | Monsieur Phi

Pingback: Raisonnement Bayésien | Pearltrees

salut,

Y a t il un lien direct de ce théorème de Bayes avec le paradoxe de Simpson?

Merci

Non il n’y a aucun lien ! La première cause du paradoxe de Simpson vient du fait qu’une somme de 2 lois binomiales n’est binomiale que si les probabilités qui les définissent sont égales. de façon plus explicite, on lance 100 fois une pièce de 1 € qui a une probabilité 30% de tomber sur pile et 100 fois une pièce de 2€ qui a 60% de chances de tomber sur pile. En cumulant les résultats on dit qu’on a lancé 200 fois une pièce qui a 45% de chances de tomber sur pile. le problème est que la pièce ainsi définie ne modélise pas la situation, d’où des erreurs et, si on le veut, des paradoxes.

On retrouve cela dans les études cas-témoins où l’on compare les binomiales des cas et des témoins comme par exemple cas et témoins ont-ils la même probabilité d’avoir été vaccinés ? Fondamentalement le test correspond au test de comparaison de 2 pièces de monnaies : ont-elles une même probabilité de tomber sur pile ? Un gros problème apparait quand les cas sont eux mêmes le cumul de 2 binomiales aux probabilités très différentes. Cela se rencontre facilement en pratique, en particulier quand les auteurs testent en cas-témoins sur des délais (la maladie apparait dans l’année qui suit la vaccination par exemple).

En voici un exemple réel pris dans la publication Tardieu 2007 sur la sclérose en plaques (SEP) chez les enfants. Ils ont retenu 143 cas de SEP dont 80 avaient été vaccinés hépatite B et 63 non vaccinés HB. 62 cas sont apparus dans les 4 années qui suivaient cette vaccination hépatite B. ces 62 cas sont évidemment parmi les 80 vaccinés HB. On peut estimer pour ces 80 cas leur probabilité d’être dans les 4 premières années par 63/80=72,5%. Pour les 63 cas non vaccinés HB leur probabilité d’être dans les 4 premières années est nulle. En testant avec les 143 cas (ce que les auteurs ont fait) c’est comme si on avait obtenu 62 piles avec une pièce lancée 80 fois et 0 pile avec une autre lancée 63 fois car elle a 2 côtés faces. On cumule les 2 résultats et on modélise par une pièce lancée 143 avec la probabilité moyenne observée 62/143=43,4%. Idem avec les témoins.

Que vaut alors le test ? Il conclut à l’absence de signal statistique qui signifie seulement que cas et témoins se comportent de la même façon par rapport au délai de 4 ans et à son délai complémentaire (égalité statistique des moyennes), Pourtant, cas et témoins ne sont pas neutres par rapport à ces délais car il y a 476 témoins sur les 4 premières années contre 102 les 2 années suivantes soit 4,7 fois moins alors qu’il faudrait 2 fois moins et de même pour les cas avec 62 sur 4 ans et 12 pour les 2 années suivantes soit 5 fois moins. Ces écarts sont statistiquement très significatifs.

C’est une forme du paradoxe de Simpson : cas et témoins se comportent de la même façon par rapport à ces délais alors que les cas entre-eux ne se comportent pas du tout de la même façon !

Le fait de conserver dans les calculs les 63 cas non vaccinés HB pour étudier une éventuelle incubation à partir de cette vaccination revient analogiquement à conserver des souris non fécondées pour étudier une durée de gestation ! Auteurs et commentateurs « autorisés » n’ont rien vu…

J’avais exposé ces questions au congrès Adelf-Sfsp d’Amiens de 4-6 octobre 2017. résumé et diaporama (muet) en ligne sur le site du congrès http://www.adelf-sfsp.fr/?p=15493

bonjour monsieur Bernard,

Je vous remercie pour ce grand exposé. Je saisi l’idée générale mais dans tous ses détails il me faut un peu de temps. Cependant je lui accorde un grand intérêt car je travaille actuellement sur le paradoxe de Simpson. J’ai par ailleurs téléchargé votre exposé du congrès en espérant qu’il puisse m’aider à bien cerner ce que vous avez dit.

Bonjour Hermann

Bernard suffira ! A votre disposition pour d’autres explications. J’ai d’ailleurs des articles sur mon blog sur ces questions :

Un signal fort oublié : http://questionvaccins.canalblog.com/archives/2018/01/14/36048343.html

Réponse de Roger Salamon,10 ans président du HCSP, à ce signal « oublié » : http://questionvaccins.canalblog.com/archives/2018/03/21/36250419.html

Beaucoup de bruit pour un signal qui n’existait pas : http://questionvaccins.canalblog.com/archives/2018/02/07/36121962.html

et d’autres encore

je vous remercie beaucoup pour toutes ces nouvelles choses que vous m’apprenez. Je m’intéresse beaucoup depuis peu au statistiques, à la probabilité et à l’induction du coup votre aide est la bienvenue. je vais sur votre blog pour en apprendre plus monsieur Bernard. 😉 merciii

Pingback: À VOIR | Pearltrees

À ce que je comprends en toute modestie, ça marche si les conditions restent stables. C’est la variation éventuelle des 0,1% de personnes atteintes de cancer dans la population qui est la clef des « sachant que ». Mais qu’un phénomène viennent provoquer l’augmentation des cancers (des radiations terribles imprévisibles issues de la galaxie d’andromède par ex), pour atteindre 60% de cancers dans la population, et alors, d’après mes calculs (c’est là aussi que les risques sont maximum, hem hem), la chance que j’ai le cancer sachant que le test est positif passe à 98% !

Est-ce que c’est vrai ce que je dis ou est-ce que je me trompe ?

Le problème, c’est que le médecin fait un test non pas sur n’importe qui, mais sur une personne sur lesquels il y a une présomption de maladie, et non au hasard dans la population. Donc il considère que la fiabilité du test est proche de 100%.

C’est le problème de vouloir étendre les tests VIH à une plus large population. J’avais calculé qu’on aurait 7,5x plus de faux positifs que de soi-disant vrais positifs (qui sont d’ailleurs eux-mêmes faux, car il ne s’agit pas d’une maladie virale).

http://www.sidasante.com/science/scitests.htm

Pingback: Comment traiter une probabilité ? – Tranxen.fr

Pingback: Covid-19, tests PCR et faux positifs. - Ze Rhubarbe Blog

Merci David.

Tu écris que « Quand une question de ce genre est présentée à des médecins, une écrasante majorité d’entre eux se trompent lourdement ». Pourrais-tu stp mentionner la référence.

C’est un vieil article, mais oui en effet j’aurai pu mieux référencer le truc !

Ce sont principalement les travaux de Gigerenzer

Par exemple pour une ref technique https://kops.uni-konstanz.de/bitstream/handle/123456789/28029/Gigerenzer_280290.pdf

Ou pour une revue plus large https://www.bbc.com/news/magazine-28166019

David, tu écris : « Autre source d’erreur classique, sous-estimer la possibilité de faire partie des faux positifs. Dans ce test, les sains apparaitront négatifs dans 97% des cas, mais positifs dans les 3% restants : ce sont les faux positifs. Intuitivement quand on considère ce chiffre de 3%, on se dit que c’est très faible et qu’on n’en fait certainement pas partie. Mais on se trompe, car quand la maladie est globalement rare (ici 0.1%), la probabilité d’être dans les faux positifs est beaucoup plus importante. »

Pourtant, si je comprends bien ton énoncé :

– P(+|M) = 90% –> P(-|M) = 10%

– P(-|S) = 97% –> P(+|S) = 3%

Or la probabilité de faux positif c’est bien P(+|S) = 3%.

Ou, autrement formulé :

P(+|S) = N(+⋂S) / N(S) –>

P(+|S) = 0,03 * 10.000 * 0,999 / 10.000 * 0,999

P(+|S) = 0,03

Donc je ne comprends pas ton paragraphe. Pourrais-tu donner un exemple chiffré stp.

Merci David.

Il semble que ce que l’on entend par « faux positif » n’est pas P(+|S) mais P(S|+). Donc alors effectivement :

p(S | +) = N(S ⋂ +) / N(+) ⇒

Soit une population de 10.000 :

p(S | +) = 0,03 * 10.000 * (1 – 0,001) / ( 0,9 * 10.000 * 0,001 + 0,03 * 10.000 * (1 – 0,001) ) ⇔

p(S | +) = 0,03 * (1 – 0,001) / ( 0,9 * 0,001 + 0,03 * (1 – 0,001) ) ≈ 0,971.

Sur 100 positifs il y a donc environ 97 personnes saines !

Mais alors David ta phrase « Dans ce test, les sains apparaitront négatifs dans 97% des cas, mais positifs dans les 3% restants : ce sont les FAUX POSITIFS » sème quelque peu la confusion, non ?

Je crois comprendre que :

P(+|S) valeur p

P(S|+) faux positif

(S = sain)

Quelqu’un pourrait-il confirmer ou infirmer cette double affirmation, et mentionner ses sources. Merci.

Je suis testé une fois positif et une fois négatif pour un test angine avec une sensibilité de 98 % et une spécificité de 94% je ne comprends pas pourquoi il faut prendre la proportion de malade d’angine bactérienne dans toute la population et non dans la population de ceux qui vont se faire tester, qui ont une angine bactérienne ou virale….